R-squared (R2)

Det måler andelen av variasjonen i avhengig variabel forklart av alle uavhengige variabler i modellen. Det forutsetter at hver uavhengig variabel i modellen bidrar til å forklare variasjonen i den avhengige variabelen., I virkeligheten, noen uavhengige variabler (prediktorer) ikke bidrar til å forklare avhengige (target) variabel. Med andre ord, noen variabler bidrar ikke i å forutsi target variable.

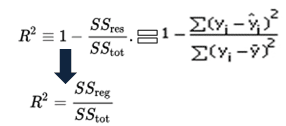

Matematisk, R-squared er beregnet ved å dele summen av kvadratene av rester (SSres) av sum av kvadrater (SStot) og deretter trekke det fra 1. I dette tilfellet, SStot tiltak total variasjon. SSreg tiltak forklart variasjon og SSres tiltak uforklart variasjon.,

Som SSres + SSreg = SStot, R2 = Forklart variasjon / Total Variasjon

R-squared Ligningen

R-Squared er også kalt determinasjonskoeffisient. Den ligger mellom 0% og 100%. En r-kvadrerte verdien av 100% betyr at modellen forklarer all variasjon av målet variabel. Og en verdi på 0% tiltak null prediktiv kraft av modellen. Høyere R-kvadrerte verdien, bedre modell.

Justert R-Kvadrert

Det måler andelen av variasjonen forklart av bare de uavhengige variablene som virkelig kan hjelpe i å forklare den avhengige variabelen., Det straffer deg for å legge til uavhengige variabelen som ikke hjelpe i å predikere den avhengige variabelen.

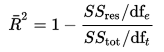

Justert R-Kvadrert kan beregnes matematisk i form av summen av kvadrater. Den eneste forskjellen mellom R-square og Justert R-kvadrat-ligningen er grad av frihet.

Justert R-Kvadrert Ligningen

I ligningen over, funksjonaliteten er frihetsgrader n– 1 i beregningen av befolkningen variansen i den avhengige variabelen, og dfe er frihetsgrader n – p – 1 i beregningen av den underliggende populasjonen feil varians.,

Justert R-kvadrerte verdien kan beregnes på grunnlag av verdien av r-squared, antall uavhengige variabler (prediktorer), total utvalgsstørrelse.

Justert R-Kvadrert Ligning 2

Forskjellen mellom R-square og Justert R-kvadrat

- Hver gang du legger til en uavhengig variabel til en modell, den R-kvadrerte øker, selv om den uavhengige variabelen er ubetydelig. Det har aldri avtar. Mens Justert R-kvadrert bare øker når den uavhengige variabelen er signifikant og påvirker avhengige variabelen.,

- Justert r-kvadrert kan være negativ når r-squared er nær null.

- Justert r-kvadrert verdi alltid vil være mindre enn eller lik r-kvadrerte verdien.

I tabellen nedenfor, justert r-kvadrert er maksimal når vi inkluderte to variabler. Det avtar når tredje variabel er lagt til. Mens r-squared øker når vi inkluderte tredje variabel. Det betyr tredje variabel er ubetydelig til modellen.

R-Squared vs. Justert R-Kvadrert

Justert R-kvadrat bør brukes til å sammenligne modeller med forskjellig antall uavhengige variabler. Justert R-kvadrat bør brukes mens du velger viktige prediktorer (uavhengige variabler) for regresjonsmodellen.

R : beregning av R-Squared og Justert R-Kvadrert

Tenk deg at du har faktiske og anslåtte avhengige variable verdier. I skriptet nedenfor, har vi laget et eksempel på disse verdiene. I dette eksemplet, y refererer til den observerte avhengig variabel og yhat viser til de foreslåtte avhengige variabelen.,

Siste Resultat : R-Squared = 0.6410828

La oss anta at du har tre uavhengige variabler i dette tilfellet.

n = 10

p = 3

adj.r.squared = 1 – (1 – R. kvadrat) * ((n – 1)/(n-p-1))

print(adj.r.squared)

I dette tilfellet, justert r-kvadrerte verdien er 0.4616242 forutsatt at vi har 3 prediktorer og 10 observasjoner.