R-squared (R2)

Den mäter andelen av variationen i din beroende variabel som förklaras av alla dina oberoende variabler i modellen. Det förutsätter att varje oberoende variabel i modellen bidrar till att förklara variation i den beroende variabeln., I verkligheten hjälper vissa oberoende variabler (prediktorer) inte att förklara beroende (mål) variabel. Med andra ord bidrar vissa variabler inte till att förutsäga målvariabel.

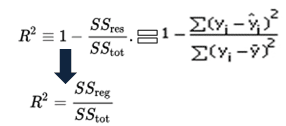

matematiskt beräknas R-squared genom att dividera summan av kvadrater av residualer (SSres) med den totala summan av kvadrater (SStot) och sedan subtrahera den från 1. I detta fall mäter sstot total variation. SSreg åtgärder förklarade variation och SSres åtgärder oförklarlig variation.,

som SSres + SSreg = Sstot, R2 = Explained variation / Total Variation

R-squared ekvation

R-Squared kallas också bestämningskoefficient. Det ligger mellan 0% och 100%. Ett R-kvadrerat värde på 100% innebär att modellen förklarar all variation av målvariabeln. Och ett värde på 0% mäter noll prediktiv effekt av modellen. Högre R-kvadrat värde, bättre modellen.

justerade R-Squared

det mäter andelen variation som förklaras av endast de oberoende variabler som verkligen hjälper till att förklara den beroende variabeln., Det straffar dig för att lägga till oberoende variabel som inte hjälper till att förutsäga den beroende variabeln.

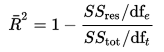

justerade R-kvadrat kan beräknas matematiskt i form av summan av kvadrater. Den enda skillnaden mellan R-kvadrat och justerad R-kvadrat ekvation är graden av frihet.

justerad r-kvadrerad ekvation

i ovanstående ekvation är DFT frihetsgraderna n– 1 av uppskattningen av befolkningsvariansen hos den beroende variabeln, och dfe är frihetsgraderna n – p – 1 av uppskattningen av den underliggande populationsfelvariansen.,

justerat r-kvadratvärde kan beräknas baserat på värdet av r-kvadrat, antal oberoende variabler (prediktorer), total provstorlek.

justerad R-Squared ekvation 2

skillnaden mellan r-square och justerad r-square

- varje gång du lägger till en oberoende variabel till en modell ökar R-squared, även om den oberoende variabeln är obetydlig. Det minskar aldrig. Medan justerade R-kvadrat ökar endast när oberoende variabel är signifikant och påverkar beroende variabel.,

- justerad R-squared kan vara negativ när r-squared är nära noll.

- justerat r-kvadratvärde alltid vara mindre än eller lika med R-kvadrat värde.

i tabellen nedan är justerat R-kvadrat maximalt när vi inkluderade två variabler. Den minskar när tredje variabeln läggs till. Medan r-kvadrat ökar när vi inkluderade tredje variabel. Det betyder att tredje variabeln är obetydlig för modellen.

R-Squared vs justerad R-Squared

justerat r-square bör användas för att jämföra modeller med olika antal oberoende variabler. Justerad R-kvadrat bör användas när du väljer viktiga prediktorer (oberoende variabler) för regressionsmodellen.

R : beräkna R-kvadrat och justerat R-kvadrat

anta att du har faktiska och förutsagda beroende variabelvärden. I skriptet nedan har vi skapat ett urval av dessa värden. I detta exempel hänvisar y till den observerade beroende variabeln och yhat hänvisar till den förutsagda beroende variabeln.,

slutresultat : R-Squared = 0.6410828

låt oss anta att du har tre oberoende variabler i det här fallet.

n = 10

p = 3

adj.R.squared = 1 – (1 – R. squared) * ((n – 1)/(n-p-1))

print(adj.R.squared)

I detta fall är justerat R-squared värde 0,4616242 förutsatt att vi har 3 prediktorer och 10 observationer.